Confident AI versus LLM Labs

Confident AI

Ideal Para

Avaliar a prontidão para produção de aplicações LLM

Aprimorar modelos LLM por meio de monitoramento contínuo

Gerenciar conjuntos de dados para eficiência

Integrar feedback dos usuários para melhorias.

Forças Chave

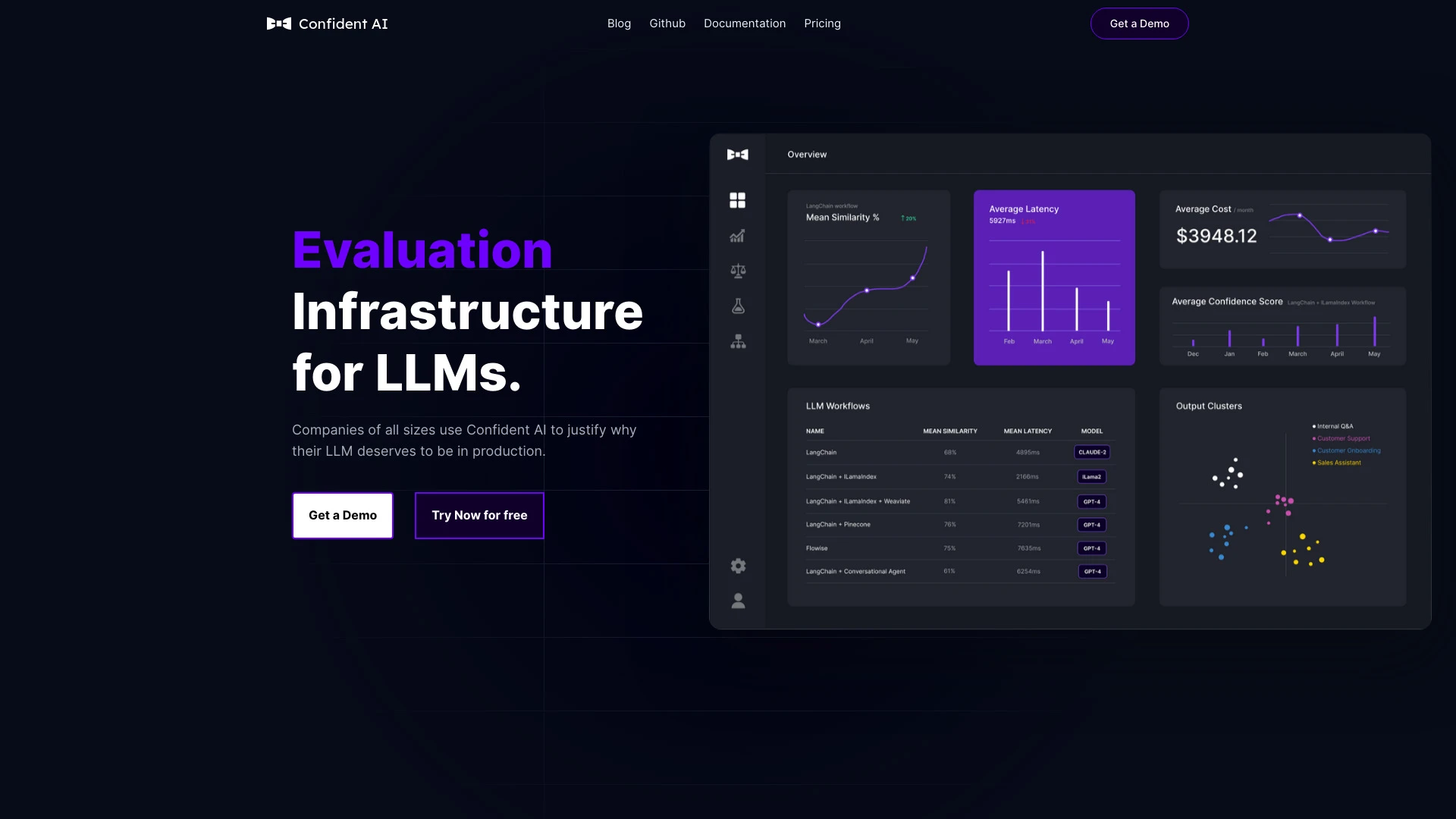

Métricas abrangentes para avaliação profunda

Facilita melhorias automáticas via feedback humano

Interface amigável para gerenciar conjuntos de dados

Recursos Principais

14+ métricas para experimentos de LLM

Gerenciamento de datasets

Monitoramento de desempenho

Integração de feedback humano

Compatibilidade com o framework DeepEval.

LLM Labs

Ideal Para

Desenvolvedores independentes avaliando modelos de linguagem

entusiastas de IA testando novas tecnologias

pesquisadores comparando desempenho de modelos

startups selecionando soluções de linguagem

Forças Chave

Permite comparações lado a lado

Economiza tempo na avaliação de modelos

Aumenta a produtividade para desenvolvedores

Recursos Principais

Teste simultâneo de múltiplos modelos de linguagem

Comparações de desempenho visual

Interface amigável lado a lado

Análise detalhada de usabilidade

Fácil login com conta do Google.